Machine Learning adalah teknologi hebat yang bisa digunakan dan akan menjadi hal yang menyenangkan ketika kamu belajar menggunakannya dengan cara yang benar. Setelah mempelajari cara menggunakan ML, itu akan menjadi sangat nyaman. Kamu bisa bermain dengan data, melatih model yang kamu kembankan sendiri, membuat algoritma yang cocok dan menemukan metode baru. Ini semua dapat kamu dimungkinkan setelag kamu berhasil menguasai tools dalam Machine Learning.

Machine Learning sendiri memiliki banyak sekali tools, software dan platform yang bisa digunakan. Selain itu, teknologi terus maju kedepan. Ini berarti masih ada teknologi baru yang selalu ditemukan. Kamu harus memilih untuk bekerja pada tools tertentu untuk mendapatkan pengalaman dengan hasil yang terbaik.

Pada artikel ini akan berisi apa saja aplikasi machine learning tersebut:

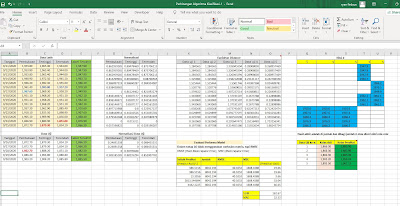

1. Microsoft Excel

Kamu mungkin tak akan asing dengan nama microsoft excel. Aplikasi yang terus dikembangkan oleh microsoft corporation ini merupakan aplikasi khusus untuk pengolahan data. Seiring dengan berjalannya.

2. RapidMiner Studio

Adalah sebuah aplikasi atau Sofware peragkat lunak yang berfungsi sebagai alat pembelajan pada ilmu data mining. platfrom dikembangkan oleh suatu perusahaan yang bertujuan untuk bisnis komersial, penelitian, pendidikan, pelatihan, serta semua langkah dalam pembelajaran yang menyangkut pada suatu data yang besar.

Rapidminer adalah platform data science, Ini adalah antarmuka yang luar biasa dan cukup membantu untuk non-programmer. Tools Machine Learning ini berfungsi pada sistem operasi lintas platform. Biasanya digunakan di perusahaan dan industri untuk pengujian data dan model dengan cepat dengan penggunaan yang benar.

User Interface rapidminer studio ini menyediakan platform yang mudah digunakan. Dalam hal ini, kamu dapat menempatkan data kamu sendiri dan menguji model kamu sendiri. Maka dengan komputasi yang cepat akan memberikan hasil yang baik.

Selain digunakan untuk bidang Industri, Rapidminer studio ini juga menyediakan paltform bagi para pelajar dan bisa digunakan secara gratis.

3. R Studio

R adalah sebuah bahasa pemrograman khusus untuk statistik dan komputasi grafik. Kelebihan dari R adalah syntac yang ringkas dan kemudahan untuk menghasilkan plot berkualitas yang bisa dipakai publikasi termasuk simbol dan rumus matematika.

R biasa digunakan untuk keperluan uji statistik, pomodelan linier dan nonlinier, analisis deret waktu, klasifikasi dan lain sebagainya.

Rstudio adalah IDE yang digunakan dengan bahasa R. Rstudio sedikit berbeda dari R, karena R adalah bahasa pemrograman. Ini juga adalah antarmuka terbaik untuk Bahasa R.

R biasanya digunakan untuk analisis data dan fungsi terkait data. Rstudio menjadikan R alat yang sanagat kuat untuk digunakan. Anaconda menyediakan akses ke Rstudio.

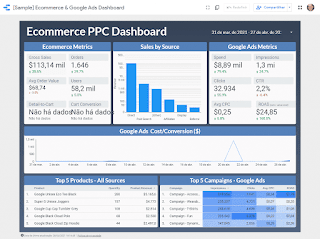

4. Google Data Studio

Google Data Studio memudahkan kita mendapatkan data dari berbagai sumber tanpa pemrograman. Anda bisa terhubung pada sumber dataset seperti :

- Google Marketing Platform, termasuk Google Ads, Analytics, Display & Video 360, Search Ads 360.

- Produk konsumen Google, seperti Sheets, YouTube, dan Search Console.

- Database, termasuk BigQuery, MySQL, and PostgreSQL.

- Upload CSV file dan Google Cloud Storage.

- Media sosial seperti Facebook, Reddit, and Twitter.

5. Google Cloud AutoML

Konsep dasar cloud autoML adalah membuat Artificial Intelegencia dapat diakses oleh semua orang. Ini juga bisa digunakan untuk bisnis.

Cloud AutoML menyediakan model terlatih untuk membuat berbagai layanan. Layanan ini mencakup semuanya, mulai dari Ucapan, pengenalan teks dll.

Google AutoML saat ini mulai populer di kalangan perusahaan. Sangat sulit untuk menyebarkan AI di steiap bidang. Ini disebabkan karena setiap sektor tidak memiliki orang yang ajli dalam AI atau ML. Jadi Google telah menciptakan platform Cloud AutoML yang menyediakan model dan telah dilatih sebelumnya. Sehingga ini akan membantu banyak sekali users.

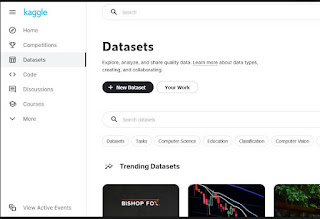

6. Kaggle

Buat kalian yang mau cari dataset untuk latihan dan buat portofolio data, Kaggle jadi tempat yang tepat. Kaggle adalah anak perusahaan dari Google LLC sebagai wadah berkumpulnya praktisi data dan pembelajaran mesin. Kaggle membantu kita untuk menemukan kumpulan data, diskusi dengan data analis lain, kursus data, dan ada juga kompetisi berhadiah puluhan ribu dollar.

7. Weka

Weka adalah alat machine learning yang berbasis open source dan diakses melalui GUI. Ini adalah perangkat lunak yang ramah dan bisa digunakan dalam pembelajaran dan penelitian.

Weka memiliki berbagai aplikasi industri. Juga, ini menyediakan akses ke berbagai alat lain dalam machine learning yang termasuk Scikit-learn, R , dan lain sebagainya.

8. Phyton

Python pertama kali dirilis oleh Python Software Foundation dan didesain oleh Guido van Rossum pada tahun 1991. Dalam beberapa tahun terakhir, Python telah mengembangkan berbagai layanan untuk mendukung pekerjaan di bidang analisis data, komputasi interaktif, dan visualisasi data. Beberapa library Python yang terkenal adalah Numpy, Pandas, dan Scikit-learn.

Library yang ada di Python:

a. Scikit-Learn

Scikit Learn adalah aplikasi berbasis open source di machine learning, Pada aplikasi ini juga menyediakan platform terpadu untuk user. Yang didalmnya bisa membantu dalam Regresi, Klasifikasi, dan Klaster.

b. Tenserflow

Tenserflow adalah framework berbasis open source untuk ML numerik dan skala besar. Ini menggunakan model ML dan neural network models.

Tenserflow adalah tools ML yang ramah dengan python. Ini berjalan pada CPU dan GPU, selain menjalankan model neural network juga bisa untuk Klasifikasi gambar, NLP, dll.

c. Pytorch

Pytorch adalah kerangka kerja deep learning. Aplikasi ini membuat penggunaan GPU yang sangat kuat, sehingga membuatnya sangat cepat dan fleksibel untuk digunakan.

Pytorch berguna karena digunakan dalam aspek ML yang sangat penting. Nah, Pytorch ini sepenuhnya berbasis Python dan merupakan pengganti untuk NumPy. Ini katanya memiliki masa depan yang besar karena masih pemain muda di Industri Data Science.